ETCD的内存问题

今天跟大家分享一个etcd的内存大量占用的问题,这是前段时间在我们开源软件Easegress中遇到的问题,问题是比较简单的,但是我还想把前因后果说一下,包括,为什么要用etcd,使用etcd的用户场景,包括etcd的一些导致内存占用比较大的设计,以及最后一些建议。希望这篇文章不仅仅只是让你看到了一个简单的内存问题,还能让你有更多的收获。当然,也欢迎您关注我们的开源软件,给我们一些鼓励。

今天跟大家分享一个etcd的内存大量占用的问题,这是前段时间在我们开源软件Easegress中遇到的问题,问题是比较简单的,但是我还想把前因后果说一下,包括,为什么要用etcd,使用etcd的用户场景,包括etcd的一些导致内存占用比较大的设计,以及最后一些建议。希望这篇文章不仅仅只是让你看到了一个简单的内存问题,还能让你有更多的收获。当然,也欢迎您关注我们的开源软件,给我们一些鼓励。

为什么要用ETCD

先说一下为什么要用etcd。先从一个我们自己做的一个API网关 – Easegress(源码)说起。

Easegress 是我们开发并开源的一个API应用网关产品,这个API应用网关不仅仅只是像nginx那样用来做一个反向代理,这个网关可以做的事很多,比如:API编排、服务发现、弹力设计(熔断、限流、重试等)、认证鉴权(JWT,OAuth2,HMAC等)、同样支持各种Cloud Native的架构如:微服务架构,Service Mesh,Serverless/FaaS的集成,并可以用于扛高并发、灰度发布、全链路压力测试、物联网……等更为高级的企业级的解决方案。所以,为了达到这些目标,在2017年的时候,我们觉得在现有的网关如Nginx上是无法演进出来这样的软件的,必需重新写一个(后来其他人也应该跟我们的想法一样,所以,Lyft写了一个Envoy。只不过,Envoy是用C++写的,而我用了技术门槛更低的Go语言)

另外,Easegress最核心的设计主要有三个:

- 一是无第三方依赖的自己选主组集群的能力

- 二是像Linux管道命令行那样pipeline式的插件流式处理(支持Go/WebAssembly)

- 三是内置一个Data Store用于集群控制和数据共享。

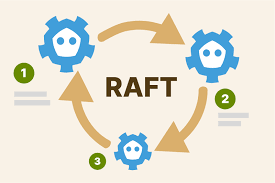

对于任何一个分布式系统,都需要有一个强一制性的基于Paxos/Raft的可以自动选主机制,并且需要在整个集群间同步一些关键的控制/配置和相关的共享数据,以保证整个集群的行为是统一一致的。如果没有这么一个东西的话,就没有办法玩分布式系统的。这就是为什么会有像Zookeeper/etcd这样的组件出现并流行的原因。注意,Zookeeper他们主要不是给你存数据的,而是给你组集群的。

Zookeeper是一个很流行的开源软件,也被用于各大公司的生产线,包括一些开源软件,比如:Kafka。但是,这会让其它软件有一个依赖,并且在运维上带来很大的复杂度。所以,Kafka在最新的版本也通过内置了选主的算法,而抛弃了外挂zookeeper的设计。Etcd是Go语言社区这边的主力,也是kubernetes组建集群的关键组件。Easegress在一开始(5年前)使用了gossip协议同步状态(当时想的过于超前,想做广域网的集群),但是后发现这个协议太过于复杂,而且很难调试,而广域网的API Gateway也没遇到相应的场景。所以,在3年前的时候,为了稳定性的考量,我们把其换成了内嵌版本的etcd,这个设计一直沿用到今天。

Easegress会把所有的配置信息都放到etcd里,还包括一些统计监控数据,以及一些用户的自定义数据(这样用户自己的plugin不但可以在一条pipeline内,还可以在整个集群内共享数据),这对于用户进行扩展来说是非常方便的。软件代码的扩展性一直是我们追求的首要目标,尤其是开源软件更要想方设法降低技术门槛让技术易扩展,这就是为什么Google的很多开源软件都会选使用Go语言的原因,也是为什么Go正在取代C/C++的做PaaS基础组件的原因。

背景问题

好了,在介绍完为什么要用etcd以后,我开始分享一个实际的问题了。我们有个用户在使用 Easegress 的时候,在Easegress内配置了上千条pipeline,导致 Easegress的内存飙升的非常厉害- 10+GB 以上,而且长时间还下不来。

用户报告的问题是——

在Easegress 1.4.1 上创建一个HTTP对象,1000个Pipeline,在Easegres初始化启动完成时的内存占用大概为400M,运行80分钟后2GB,运行200分钟后达到了4GB,这期间什么也没有干,对Easegress没有进行过一次请求。

一般来说,就算是API再多也不应该配置这么多的处理管道pipeline的,通常我们会使用HTTP API的前缀把一组属于一个类别的API配置在一个管道内是比较合理的,就像nginx下的location的配置,一般来说不会太多的。但是,在用户的这个场景下配置了上千个pipeline,我们也是头一次见,应该是用户想做更细粒度的控制。

经过调查后,我们发现内存使用基本全部来自etcd,我们实在没有想到,因为我们往etcd里放的数据也没有多少个key,感觉不会超过10M,但不知道为什么会占用了10GB的内存。这种时候,一般会怀疑etcd有内存泄漏,上etcd上的github上搜了一下,发现etcd在3.2和3.3的版本上都有内存泄露的问题,但都修改了,而 Easegress 使用的是3.5的最新版本,另外,一般来说内存泄漏的问题不会是这么大的,我们开始怀疑是我们哪里误用了etcd。要知道是否误用了etcd,那么只有一条路了,沉下心来,把etcd的设计好好地看一遍。

大概花了两天左右的时间看了一下etcd的设计,我发现了etcd有下面这些消耗内存的设计,老实说,还是非常昂贵的,这里分享出来,避免后面的同学再次掉坑。

首当其冲是——RaftLog。etcd用Raft Log,主要是用于帮助follower同步数据,这个log的底层实现不是文件,而是内存。所以,而且还至少要保留 5000 条最新的请求。如果key的size很大,这 5000条就会产生大量的内存开销。比如,不断更新一个 1M的key,哪怕是同一个key,这 5000 条Log就是 5000MB = 5GB 的内存开销。这个问题在etcd的issue列表中也有人提到过 issue #12548 ,不过,这个问题不了了之了。这个5000还是一个hardcode,无法改。(参看 DefaultSnapshotCatchUpEntries 相关源码)

// DefaultSnapshotCatchUpEntries is the number of entries for a slow follower // to catch-up after compacting the raft storage entries. // We expect the follower has a millisecond level latency with the leader. // The max throughput is around 10K. Keep a 5K entries is enough for helping // follower to catch up. DefaultSnapshotCatchUpEntries uint64 = 5000

另外,我们还发现,这个设计在历史上etcd的官方团队把这个默认值从10000降到了5000,我们估计etcd官方团队也意识到10000有点太耗内存了,所以,降了一半,但是又怕follwer同步不上,所以,保留了 5000条……(在这里,我个人感觉还有更好的方法,至少不用全放在内存里吧……)

另外还有下面几项也会导致etcd的内存会增加

- 索引。etcd的每一对 key-value 都会在内存中有一个 B-tree 索引。这个索引的开销跟key的长度有关,etcd还会保存版本。所以B-tree的内存跟key的长度以及历史版本号数量也有关系。

- mmap。还有,etcd 使用 mmap 这样上古的unix技术做文件映射,会把他的blotdb的内存map到虚拟内存中,所以,db-size越大,内存越大。

- Watcher。watch也会占用很大的内存,如果watch很多,连接数多,都会堆积内存。

(很明显,etcd这么做就是为了一个高性能的考虑)

Easegress中的问题更多的应该是Raft Log 的问题。后面三种问题我们觉得不会是用户这个问题的原因,对于索引和mmap,使用 etcd 的 compact 和 defreg (压缩和碎片整理应该可以降低内存,但用户那边不应该是这个问题的核心原因)。

针对用户的问题,大约有1000多条pipeline,因为Easegress会对每一条pipeline进行数据统计(如:M1, M5, M15, P99, P90, P50等这样的统计数据),统计信息可能会有1KB-2KB左右,但Easegress会把这1000条pipeline的统计数据合并起来写到一个key中,这1000多条的统计数据合并后会导致出现一个平均尺寸为2MB的key,而5000个in-memory的RaftLog导致etcd要消耗了10GB的内存。之前没有这么多的pipeline的场景,所以,这个内存问题没有暴露出来。

于是,我们最终的解决方案也很简单,我们修改我们的策略,不再写这么大的Value的数据了,虽然以前只写在一个key上,但是Key的值太大,现在把这个大Key值拆分成多个小的key来写,这样,实际保存的数据没有发生变化,但是RaftLog的每条数据量就小了,所以,以前是5000条 2M(10GB),现在是5000条 1K(500MB),就这样解决了这个问题。相关的PR在这里 PR#542 。

总结

要用好 etcd,有如下的实践

- 避免大尺寸的key和value,一方面会通过一个内存级的 Raft Log 占大量内存,另一方面,B-tree的多版本索引也会因为这样耗内存。

- 避免DB的尺寸太大,并通过 compact和defreg来压缩和碎片整理降低内存。

- 避免大量的Watch Client 和 Watch数。这个开销也是比较大的。

- 最后还有一个,就是尽可能使用新的版本,无论是go语言还是etcd,这样会少很多内存问题。比如:golang的这个跟LInux内核心相关的内存问题 —— golang 1.12的版sget的是

MADV_FREE的内存回收机制,而在1.16的时候,改成了MADV_DONTNEED,这两者的差别是,FREE表示,虽然进程标记内存不要了,但是操作系统会保留之,直到需要更多的内存,而DONTNEED则是立马回收,你可以看到,在常驻内存RSS 上,前者虽然在golang的进程上回收了内存,但是RSS值不变,而后者会看到RSS直立马变化。Linux下对MADV_FREE的实现在某些情况下有一定的问题,所以,在go 1.16的时候,默认值改成了MADV_DONTNEED。而 etcd 3.4 是用 来1.12 编译的。

最后,欢迎大家关注我们的开源软件! https://github.com/megaease/

(全文完)

(转载本站文章请注明作者和出处 酷 壳 – CoolShell ,请勿用于任何商业用途)

(48 人打了分,平均分: 4.46 )

(48 人打了分,平均分: 4.46 )

《ETCD的内存问题》的相关评论

错别字呢:

站用 -> 占用

调坑 -> 调坑

掉掉掉

谢谢!

10000万有点太耗内存了 -> 10000有点太耗内存了

谢谢,已修正!

Google主要使用Java语言应该是笔误,应该是go语言吧

汗,我是有多爱Java啊,不过,Google的一大开源项目Android就是用Java的……

Google 主要用的确实是 Java,几乎所有服务端都是。C++ 是第二大语言,golang 要排在后面。

虽然都姓G,haha

供享 -> 共享

谢谢,已更正。

为什么要把这些监控数据存在 etcd中,而不是提供 API 暴露 metrics 交给 prometheus 这样的软件抓取呢?

存etcd是因为整个集群需要感知这些数据。metrics API是有的,但是自己也得要存一份最新的吧,就像linux的/proc文件系统一样,不然,API请求的时候,现算?这个不太好吧。

如果不用etcd, K8S云原生KV存储这块, 请问还有更好的解决方面吗?

解决方案, 打错字了, 抱歉!

哈哈哈,我来抓虫啦:Hashicorp 拼写错了,Envoy 不是 Hashicorp 写的,最早源于 Lyft 的内部项目。

谢谢,这是我的错!已修正

“虽然只写在一个key上,而是拆分成多个小的key来写”

感觉这里的逻辑有点问题。

是不是下面的意思:

“以前只写在一个key上,现在选择拆分成多个小的key来写”

嗯,你理解是对的,我重新写了一下。

看起来核心思想就是 2kb*5K << 2MB * 5k 的问题。更新次数不变的情况下,将 key-value 的字节大小降下来。即不使用单个大 key-value 对,使用小的 key-value 对。

是的。就是降Raft Log的大小。

“而后者会看到RSS直立马变化”

一个错字

问题分析过程非常精彩,原因、结果、处理办法弄个明明白白,受教了。不过问个事后诸葛亮式的问题:先说前提,我没用过 go ,只对 java 熟悉。咱们一开始分析这个内存问题的时候是不是可以先看内存数据分类占比,类似查看 java 内存 dump 一样,这样是不是可以更快确定问题原因查找的目标。

go也有pprof 能看到heap

我:用各种工具分析观察

博主:读源码,主要这些地方在写数据,bug可能在。。。

etcd 使用 mmap 这样上古的unix技术做文件映射

mmap 有替代的技术吗?

我记得kafka也是用mmap技术,借用系统page cache但减少内存copy。不太理解这里说“上古”,是不是有什么特殊含义

CMU的数据库课程上面有说过这种实现的替换,就是buffer pool

而 etcd 3.4 是用 来1.12 编译的。

多了一个来字

感觉不像耗子叔写的,不过分析的很精彩

分析的很精彩!

请问这个 pull request 中的内存分析图是怎么画出来的:

https://github.com/megaease/easegress/pull/542#issuecomment-1067620642

像是极客时间里etcd课程里面的内容

blotdb 应该是boltdb

而后者会看到RSS直立马变化。->值

修改DefaultSnapshotCatchUpEntries 不是一样的效果吗?

如你们把10条entry 合成1条,那就将它改为500即可

这样follower会因为 raft log日志不够 同步出现问题

冋

受益很大,感谢分享

同时反馈个拼写问题

defreg –> defrag